AIと3D CGを組み合わせた新技術が登場。CG学会「SIGGRAPH 2021」でNVIDIAが発表した最新の製品や技術をレポート

|

発表内容は,大きく分けて3つ。1つはプロフェッショナル向けGPU製品。2つめはいくつかの技術論文。そして3つめは,NVIDIAが精力的に進めている3Dコラボレーションプラットフォーム「Omniverse」の最新情報についてだ。これらの概要を簡単にまとめてみたい。

450ドルのプロフェッショナル向けGPU

RTX A2000

NVIDIAは,グラフィックスワークステーションへの搭載を想定したプロフェッショナル用向けGPUとして,「NVIDIA RTX A2000」(以下,RTX A2000)を発表した。

明らかとなった主なスペックは表のとおりだ。

| GPUコア | GA106? |

|---|---|

| GPUアーキテクチャ | Ampere |

| 製造プロセス技術 | Samsung 8nm |

| トランジスタ数 | 約132.5億個 |

| ダイサイズ | 276mm2 |

| ミニGPU |

未公開(3?) |

| TPC数 | 未公開(14?) |

| 演算ユニット(SM)数 | 26 |

| シェーダプロセッサ数 | 3328 |

| RT Core数 | 26 |

| Tensor Core数 | 104 |

| テクスチャ |

未公開(104?) |

| ROP数 | 未公開 |

| ベースクロック | 未公開 |

| ブーストクロック | 未公開 |

| L2キャッシュ容量 | 未公開 |

| メモリタイプ | GDDR6(ECC対応) |

| メモリインタフェース | 192bit |

| メモリクロック | 12GHz相当 |

| メモリバス帯域幅 | 288GB/s |

| メモリ容量 | 6GB |

| TDP | 70W |

| 接続インタフェース | PCIe 4.0 x16 |

| 映像出力 |

Mini DisplayPort×4 |

| PCIe外部電源 | 未公開 |

製品名にA型番があることから推測できるように,RTX A2000には,AmpereアーキテクチャのGPUコアが採用されている。トランジスタ数は約132億5000万個で,ダイサイズは約276mm2。製造はSamsung Semiconductorの8nm製造プロセスで行われる。

総CUDAコア数は3328基,メモリインタフェースが192bitであることから,「GeForce RTX 3060」が採用している「GA106」コアと見て間違いない。

|

動作クロックは明らかになっていないものの,単精度浮動小数点演算(FP32)の理論性能値は,8 TFLOPSとなっているため,逆算するとGPU動作クロックは1.2GHz程度といったあたりになる。性能イメージも,GeForce RTX 3060をやや下回る程度,という感じか。Ampereコアなので推論アクセラレータのTensor Coreを104基,リアルタイムレイトレーシングユニットのRT Coreは26基を備える。

グラフィックスメモリはデータ転送レート12GHz相当のGDDR6で,メモリインタフェースが192bitであることから,メモリ帯域幅は288GB/sとなる。これもGeForce RTX 3060をやや下回る。グラフィックスメモリ容量はプロフェッショナル用としては小さめの6GB。ただし,使用しているメモリチップは,エラー訂正機構であるECC機能付きとなっている。

PCと接続するインタフェースは,PCI Express Gen 4.0のx16接続対応だ。

公開されたカードは2スロットデザインだが,ブラケットはロープロファイルにも対応するそうで,コンパクトなワークステーションにも搭載できるとNVIDIAはアピールしていた。ブラケットに並ぶビデオ出力端子は,Mini DisplayPort 1.4が4つで,HDMI端子はない。

|

最大消費電力は70Wなので,強力な電源ユニットや冷却機構を持たないPCにも組み込めるだろう。

|

発売は2021年10月を予定しており,北米市場におけるメーカー想定売価は450ドル(税別,約4万9800円)とのことだ。

AI×3Dグラフィックスの新しい技術も発表

SIGGRAPH 2021でNVIDIAが発表した論文と,その概要ページはすでに公開済みだ。ラインナップは以下のとおり。

- Real-Time Neural Radiance Caching for Path Tracing

- ReSTIR GI: Path Resampling for Real-Time Path Tracing

- An Unbiased Ray-Marching Transmittance Estimator

- Rearchitecting Spatiotemporal Resampling for Production

- Appearance-Driven Automatic 3D Model Simplification

- NVIDIA Research: NeRF-Tex: Neural Reflectance Field Textures

NVIDIA Graphics Research

論文のラインナップから,筆者が興味深いと感じたり,将来のゲームグラフィックスに関係が深そうだと考えたものをピックアップして,簡単に解説しよう。

まずは「Real-Time Neural Radiance Caching for Path Tracing」からだ。

これは,レイトレーシング(パストレーシングも含む)の処理系が進行する過程において,ニューラルネットワーク(分かりやすくいえばAI)を介在させて,完成形のライティング結果を推論していくレンダリング手法「ニューラルラディアンスキャッシング」に関する論文である。

|

間接照明の演算は,光源が発した光がシーン中にあるさまざまな素材でできたオブジェクトに何度も衝突(反射)する過程を追跡して,その積分値を求めていくのが基本的な流れだ。今回発表となった新技術では,演算が進行中の途中結果から,最終的な結果をニューラルネットワークで推測するものとなる。RTX系GPUが搭載するTensor Coreを使って,レイトレーシングの演算を支援するようなイメージと考えれば分かりやすいかもしれない。

NVIDIAには,ほかにもこれと近い手法として,少ないレイによるレイトレーシングで生成したノイズの多いな映像をきれいにするデノイザ(ノイズ低減技術)を,Tensor CoreベースのAIで構築した技術「NVIDIA OptiX AI Accelerated Denoiser」(NRD,関連リンク)や,同様にAIベースの技術で低解像度映像を高解像度化したりアンチエイリアス効果をかける「DLSS」(Deep Learning Super Sampling)などがある。ニューラルラディアンスキャッシングは,もう少し実レンダリング処理(≒実際のレイトレーシング処理)に近いところにAIベースの技術を介入させるものになる。

GPUに推論アクセラレータであるTensor Coreを搭載することに,さらなる意義というか,価値を持たせようとするNVIDIAのしたたかな戦略も見える面白い技術だと言えよう。

NVIDIAによるニューラルラディアンスキャッシングの説明ビデオ

「NVIDIA Research: NeRF-Tex: Neural Reflectance Field Textures」も,ニューラルラディアンスキャッシングのようにTensor Coreを実レンダリング工程と連携させる論文だ。

|

NeRF-Texと呼ばれるこの技術は,布や草,毛皮などの微細な凹凸を表現する新しいテクスチャ表現手法である。微細な凹凸からなる材質では,視点や光源の位置関係によっては,凹凸同士で遮蔽しあったり,あるいは透過した光が複雑な陰影を見せたりすることがある。そうした「見え方」と「陰影の出方」を,ニューラルネットワークで構築したテクスチャシステムで再現するというものだ。

NVIDIAによるNeRF-Texの説明ビデオ

もう1つ,「Appearance-Driven Automatic 3D Model Simplification」(以下,Auto LOD)は,ゲーム制作に応用できそうな技術で,一言で言ってしまえば,3Dモデルの低ポリゴン化を実現するものだ。

|

視点からの距離に応じて詳細度の違うポリゴンモデルを用意して,視点から遠い場合はポリゴンの少ないモデルを,視点から近い場合はポリゴンの多いモデルを利用することでGPU負荷を低減させるテクニックは,「Level of Detail」(LOD)法と呼ばれて,ゲーム業界でもかなり古くから活用されている。

このLODモデルを生成する手法は,さまざまなものがあるが,すでに広く利用されている商用ソフトとして有名なのが,「Simplygon」だろうか。

従来のLOD用モデル生成手法は,入力3Dモデルのポリゴンを削減してローポリゴンのモデルを作るものだったが,この手法は,入力3Dモデルを画面内に指定した大きさで描画した状態と見映えが同じになるように,設定したポリゴン数で(スクリプトを用いて)モデリングし直すという手法になる。

|

そのため,ゲームであればプレイ中にリアルタイムに行うのではなく,ゲームの制作段階で利用する技術になる。ちなみに,AI系の技術は使っておらず,スクリプトベースで動作するものとのことだ。

NVIDIAによるAuto LODの説明ビデオ

このほかにも,「RTXDI」ライブラリとして公開されている論文「Rearchitecting Spatiotemporal Resampling for Production」も興味深かった。興味がある人は,上述したリンクで論文をチェックしてみるといい。

Omniverseに関する新発表も

最後のテーマは,3DコラボレーションプラットフォームOmniverseだ。

4GamerでもOmniverseは何度か取り上げてはいるものの(関連記事),ゲームだけに使われるソリューションではないので,本誌読者にはあまり知られていないだろう。なので,「Omniverseとは何か」について,簡単に解説しておこう。

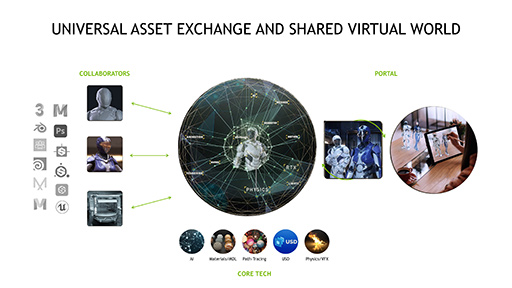

|

IT産業やゲーム産業に限らず,さまざまな産業の開発現場で,さまざまな3Dオブジェクトを扱うソフトウェアが使われている。たとえば,3D CGのモデリングを行うCG製作ソフトは,ゲームや映像制作だけでなく建築業界でも用いられている。建築物の火災シミュレーションや,建物周辺の景観も含めた環境の可視化,映像化などにも,さまざまな3D CGソフトウェアが必要だ。

しかし,工程ごとに異なるソフトを用いた場合,開発した3Dオブジェクトをあるソフトから別のソフトへ移すには,データのコンバートが必要になることも多い。また,完成した3Dシーン(仮想世界)に対して,特別なシミュレーションを新規開発して適用しなければならないときには,3Dシーンを構成するオブジェクトのデータ構造が公開されていないと,シミュレーションの開発は難しくなってしまう。

そこで,「あらゆる3D CGソフトを,共通のアーキテクチャを土台にした構造とすることで,異なるメーカー,異なるジャンルのソフトやデータを透過的に相互連携できるようにすれば便利なのでは?」とNVIDIAは考えた。これがOmniverse構想の起点になる。

|

|

Omniverseは,1台のPCで完結するものではなく,ネットワークを介して複数の人間が同時に,異なるソフトウェアを使ってリアルタイムに共同作業することも可能である。

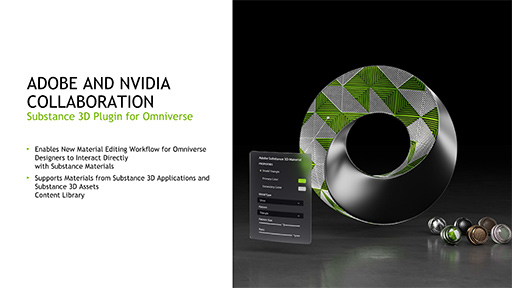

Omniverseは,NVIDIAがライセンスフリーのオープンプラットフォームとしたことから,ハードウェアおよびソフトウェアの両業界から賛同が寄せられつつある。たとえば,Adobe,Autodesk,Epic Games,Dell Technologies,Cisco Systems,Pixarといった企業が,開発と環境整備に賛同して取り組んでいるのが現状だ。

なお,Omniverseはライセンスフリーではあるものの,Omniverseのエコシステムで高い性能が得られるのは,NVIDIA製のGPUや同社の技術をベースとしたサーバを利用したときに限られる。こうした手法も,さすがはNVIDIAといったところか。それゆえに,2021年8月時点では,NVIDIA競合となるAMDやIntelはOmniverse構想に参加していない。

|

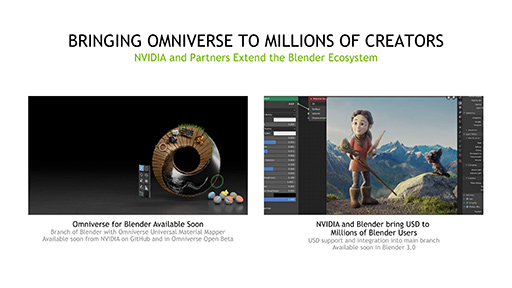

SIGGRAPH 2021でNVIDIAは,Omniverseに関するいくつかの発表を行った。スライドで簡単に紹介しておこう。

|

|

|

|

|

この中で,とくに興味深いのは,Pixar,Apple,NVIDIAが物理シミュレーション用として,Omniverseが基本シーンの記述フォーマットとして採用している「USD」(Universal Scene Description)の規格化に着手したという発表だろうか。

|

USDはもともと,Pixarが開発したものだった。そのため,3Dグラフィックスを前提としたシーン記述形式なのだが,これをグラフィックス用途だけでなく,物理シミュレーションにも拡張しようというわけだ。そして,このテーマにAppleが乗っているのが興味をそそる。

「Omniverseは,デジタルツイン業界の世界標準を目指す」とのことなので,他分野で必要となる要素に対応を広げていく可能性もありそうだ。たとえば音響シミュレーションなどは,いかにも適しそうなテーマに思える。

NVIDIAのSIGGRAPH 2021特設ページ(英語)

- 関連タイトル:

NVIDIA RTX,Quadro,Tesla

NVIDIA RTX,Quadro,Tesla

- この記事のURL:

Copyright(C)2010 NVIDIA Corporation

提供:G123