ニュース

NVIDIA,SIGGRAPH 2023に合わせてAdaベースのワークステーション向け新型GPU「RTX 5000」などを発表

|

本稿ではそれらの中から,とくにハードウェアの新製品に関して概要をまとめよう。

ワークステーション向けの新型GPU

RTX 5000/4500/4000を発表

NVIDIAは,ワークステーション向けのGPU製品「RTX Professional Graphics」を展開している。2023年1月には,Ada Lovelace(以下,Ada)アーキテクチャベースでCUDAコア数18176基の最上位モデル「RTX 6000」と,スモールフォームファクタ向けでCUDAコア数6144基の「RTX 4000 SFF」という新製品を発表していた。

SIGGRAPH 2023では,Adaベースの新型GPUとして,「RTX 5000」「RTX 4500」「RTX 4000」の3モデルが発表となった。

|

新GPUの主なスペックを表にまとめておこう。

| RTX 5000 | RTX 4500 | RTX 4000 | |

|---|---|---|---|

| GPUコア | AD102? | AD104? | AD104? |

| アーキテクチャ | Ada Lovelace | Ada Lovelace | Ada Lovelace |

| 製造プロセス技術 | TSMC 4N | TSMC 4N | TSMC 4N |

| トランジスタ数 | 約76.3億 | 約35.8億 | 約35.8億 |

| ダイサイズ | 608.4mm2 | 294.5mm2 | 294.5mm2 |

| CUDAコア総数 | 12800 | 7680 | 6144 |

| RT Core数 | 100 | 60 | 48 |

| Tensor Core数 | 400 | 240 | 192 |

| 単精度演算性能 | 65.3 TFLOPS | 39.6 TFLOS | 26.7 TFLOS |

| RT Core演算性能 | 151 TFLOPS | 91.6 TFOPS | 61.8 TFLOS |

| Tensor Core演算性能 | 1044.4 TFLOPS | 634 TFLOPS | 427.6 TFLOS |

| メモリタイプ | GDDR6 | GDDR6 | GDDR6 |

| メモリインタフェース | 256bit | 192bit | 160bit |

| メモリバス帯域幅 | 576GB/s | 432GB/s | 360GB/s |

| メモリ容量 | 32GB | 24GB | 20GB |

| フォームファクタ | PCIe 4.0 x16 2スロット占有 |

PCIe 4.0 x16 2スロット占有 |

PCIe 4.0 x16 1スロット占有 |

| GPU最大 |

250W | 210W | 130W |

| 価格 | 4000ドル | 2250ドル | 1250ドル |

| 発売日 | 8月8日 | 2023年10月 | 2023年9月 |

なお,GPUコアのコードネームは未公開なので筆者の推定だが,公表されているダイサイズやトランジスタ数から見てRTX 5000がAD102,RTX 4500とRTX 4000はAD104で間違いないだろう。

AD102は,RTX 6000や「GeForce RTX 4090」で採用されたGPUコアだ。最大で18176基のCUDAコアを集積可能なAdaアーキテクチャでは最大のGPUコアで,RTX 5000は,GPUコアの一部を無効化した製品というわけだ。

一方,RTX 4500やRTX 4000が採用するAD104は,GeForce RTX 4070シリーズに採用されたGPUコアだ。RTX 4500とRTX 4000は,どちらもAD104をカスタマイズした製品だろう。

|

|

NVIDIAによると,RTX 5000は高い性能を求めるユーザー向けとのこと。RTX 4500は,価格対性能比に優れた製品で,RTX 4000はCADやシミュレーションを行うワークステーションに適した製品とのことだった。

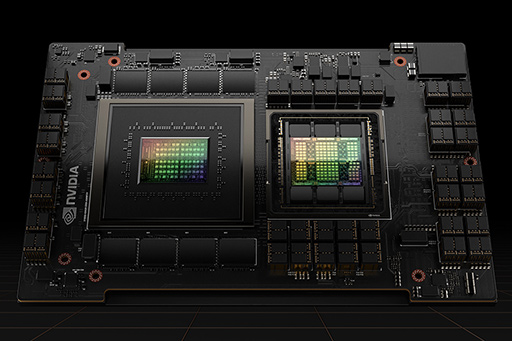

GPUではほかにも,NVIDIA製の開発プラットフォーム「NVIDIA Omniverse Enterprise」向けに展開している「NVIDIA OVX Server」用のサーバー向けGPU「L40S」が発表となった。

L40Sは,RTX 6000とほぼ同じスペックを持つGPUで,AD102コアを搭載したGPUをサーバー向けに転用したものと理解していい。新しいNVIDIA OVX Serverは,このL40Sを1サーバーあたり8基搭載して,極めて高い性能を実現しているそうだ。

|

そのほかに,「NVIDIA GH200 Grace Hopper Superchip」(以下,GH200)の次世代モデルがアナウンスされている。そもそもGH200は,NVIDIAが開発したArmベースのプロセッサ「Grace CPU」と,「Hopper」アーキテクチャベースのGPUを搭載したスーパーコンピュータボードだ(関連記事)。

|

GH200は,2023年5月のCOMPUTEX 2023で発表となり,つい最近になって量産が始まったばかりだが,早くも次世代製品がアナウンスされた格好だ。

GH200では,グラフィックスメモリとして容量96GBの「HBM3」を採用しており,メモリバス帯域幅は4TB/sを実現していた。これが次世代製品になると,グラフィックスメモリが「HBM3e」に変わり,容量は141GB,メモリバス帯域幅は5TB/sに達するそうだ。次世代のNVIDIA DGX GH200サーバーには,新しいGH200が2基搭載されるとのことである。

HBM3eは,メモリメーカーであるSK hynixがスペックなどを明らかにし始めたばかりの最新技術で,おそらくは量産も始まっていない思われる。なので,NVIDIAが明らかにした次世代型GH200も,いますぐ発売される製品ではない。NVIDIAによると,2024年第2四半期の発売を目指しているとのこと。今後も新型GH200に付いての情報は,更新されていくだろう。

Hugging Faceとの協業も発表

ソフトウェア関連の発表も多数行われたが,発表内容はAIが中心だ。

その中で,グラフィックス関連の目玉と言えるのは,NVIDIAとAI技術関連企業Hugging Faceの協業だろう。

「Stable Diffusion」のような画像生成AIを使用している人なら聞いたことがあるかもしれないが,Hugging Faceは,機械学習向けツールを開発している企業だが,AIモデルのリポジトリ(書庫)を公開,運用している企業としても知られている。さまざまな企業や団体,個人が作成したAIモデルが,Hugging Faceのコミュニティサイトで公開されており,ダウンロードして利用できる。

単に公開やダウンロードができるだけでなく,AIモデルをクラウド上で動かせるのがHugging Faceの特徴で,現在では話題の最新AIモデルが真っ先に公開される場として定着した。

NVIDIAによると,今回の協業によって,Hugging Faceが新たに開始するトレーニングサービスで「NVIDIA DGX Cloud」が利用できるようになるとのこと。AIモデルのNVIDIA製GPU向け最適化が,Hugging Faceで行えるようになるとアピールしている。NVIDIAにとっても,最新のAIモデルとGPUの親和性が高まるという意味で,意義のある協業になりそうだ。

NVIDIAのSIGGRAPH 2023特設Webページ

- 関連タイトル:

NVIDIA RTX,Quadro,Tesla

NVIDIA RTX,Quadro,Tesla

- この記事のURL:

Copyright(C)2010 NVIDIA Corporation